Aus aktuellem Anlass möchte ich gerne mein Wissen über Computer-Viren und mögliche Schutzmechanismen zur Verfügung stellen. Im letzten Jahr haben die Quantität sowie die Effektivität von Angriffen enorm zugenommen. Im Folgenden möchte ich auf diese Punkte eingehen:

- Was kann eine Antivirus-Software überhaupt leisten?

- Unter welchen Umständen versagen Antivirus-Programme?

- Wer sind eigentlich die Angreifer?

- Wie kommen Viren eigentlich auf den Rechner?

- Einfache Verhaltensregeln zur Prävention

Was kann eine Antivirus-Software überhaupt leisten?

Eine Antivirus-Software vermittelt schnell das Gefühl von Sicherheit. Aber ist dieser Schutz wirklich allumfassend? Die Antwort hierauf ist ein klares NEIN. Dies ist in den Funktionsprinzipien begründet, welche man in zwei große Bereiche aufteilen kann:

- Signaturbasierte Erkennung von Schadprogrammen

- Übertragen auf den Menschen ist dies eine Erkennung anhand eines „Fingerabdrucks“ bzw. anhand der „DNA“

- Verhaltensbasierte Erkennung von Schadprogrammen

- Es wird die Verhaltensweise von Programmen analysiert und überwacht.

- Verdächtige Programme werden im Zuge dessen analysiert und ggf. bekämpft

Die Erkennung anhand von Signaturen ist eine Art solide Grundimmunisierung. Die Merkmale von bekannten Schadprogrammen werden gesammelt und zur Identifizierung eben dieser vom Antivirus-Programm verwendet. Dies funktioniert sehr gut bei schon längerer Zeit bekannten Viren. Es ist vergleichbar mit einer Impfung, die stetig aktualisiert wird.

Tritt jedoch etwas Neues oder Geändertes auf, versagt dieser Mechanismus. Erst einige Zeit nach dem erstmaligen Auftreten (ca. 1-2 Tage) sind die neuen Viren identifiziert und wurden der Merkmalliste hinzugefügt.

Im Klartext heißt dies, dass genau HIER die signaturbasierte-Identifizierung versagt! An diesem Punkt kommt die verhaltensbasierte Erkennung ins Spiel und soll diese Lücke schließen. Von den Herstellern wird dies unter vielen Produktnamen vertrieben. Sehr beliebt ist der Begriff des cloudbasierten-Virenschutzes. Im Prinzip funktionieren sie aber alle ähnlich. Wird ein bei einem Programm ein verdächtiges Verhalten erkannt, wird dieses Programm an das Rechenzentrum des Anbieters übermittelt. Hier wird die Datei in einer Testumgebung analysiert und ggf. als gefährlich eingestuft. Der Prozess benötigt natürlich etwas Zeit und ggf. sogar eine menschliche Komponente. Bei Erkennung werden die Merkmale des Virus der Signaturliste hinzugefügt. Hierbei entstehen also die 1-2 Tage Differenz von Auftreten bis Erkennung und dem Entwickeln einer effektiven Möglichkeit der Bekämpfung. Währenddessen ist es dem Programm durch den nicht ausreichenden Schutz der Antivirus-Software auf dem Rechner möglich, großen Schaden anzurichten.

Währenddessen versucht auf dem heimischen Rechner die Antivirus-Software den Schädling einzudämmen; mit mehr oder weniger Erfolg.

Unter welchen Umständen versagen Antivirus-Programme?

Meistens versagen Antivirus-Programme bei ganz neuen Viren. Diese Programme sind darauf ausgelegt, an ihrem Verhalten nicht erkannt zu werden bzw. ihre Tätigkeiten zu verschleiern. Es kann somit sein, dass diese Programme nur durch Zufall oder einen „Fehler“ beim Verhalten erkannt werden können. Bis dahin bleibt ihr Treiben meist im Verborgenen.

Wer sind eigentlich die Angreifer?

Die gefährlichen und relevanten Angreifer sind in der Regel hochspezialisierte und höchst intelligente Personen mit krimineller Energie und dem Ziel, Profit zu erwirtschaften. Dementsprechend sind diese Gruppen professionell organisiert und fahren präzise Angriffe. Diese Angriffe können grob in zwei Gruppen unterteilt werden:

- Angriffe gegen kleine, spezielle Ziele wie z.B. ausgesuchte Firmen

- Bleiben meist lange unentdeckt

- Sind meist auf großen Schaden ausgelegt

- Ziel: Finanzielle Mittel; Know-How-Entwendung; (Auftrags-)Sabotage

- Angriffe auf die große Masse

- Möglichst viele Ziele in kurzer Zeit

- Kleinere bis größere Schäden

- Ziel: Langfristige Infizierung von Rechnern und deren Missbrauch für illegale Aktivitäten; finanzielle Mittel

Wie kommen Viren eigentlich auf den Rechner?

Typischerweise werden Schwachstellen in Programmen ausgenutzt, die eine direkte Verbindung zum Internet haben. Hierzu zählen:

- Browser (Internet Explorer, Firefox, Chrome, Safari, usw.)

- Mail-Programme (Outlook, Thunderbird, Windows Mail; usw.)

- Indirekte Programme (z.B. Java, Adobe Flash, Adobe Reader, Word, Excel, Powerpoint, usw.)

Die mit Abstand beliebteste Methode ist der Infektionsweg direkt über den Browser. Der einfache Besuch einer manipulierten Website oder einer Website mit manipulierter Werbung reicht in der Regel aus. Diese Angriffe sind so effektiv und populär, da für die Infizierung eine ganze Palette an Werkzeugen zur Verfügung steht. Es wird hierbei nicht nur eine Schwachstelle verwendet, sondern eine ganze Masse. Die Angriffsart kann kontinuierlich (im Minutentakt) geändert werden, um den Vorsprung gegenüber Antiviren-Software sowie Hersteller zu behalten und sich gegen Gegenmaßnahmen zu wehren.

Einfache Verhaltensregeln zur Prävention

Diese Frontlinie kann nur gehalten werden, solange der Benutzer durch sein Verhalten mitwirkt. Diese Verhaltensweisen sind einem aus dem realen Leben bekannt und vertraut. Diese sind nicht einmal kompliziert oder technisch sondern lassen sich mit ganz normalem Menschenverstand und Logik umsetzen:

- Banner / Meldungen im Internet, sollten nicht sorglos angeklickt werden!

- Typische Vertreter sind „ihr Rechner ist gefährdet“, „Sie haben eine neue Nachricht.“ usw. Hier sollte man sich die Frage stellen, woher eine beliebige Website diese Information überhaupt herhaben möchte. Und wieso ist diese Website SO sehr über meine Sicherheit besorgt?

- Links in E-Mails sollten nicht sorglos angeklickt werden!

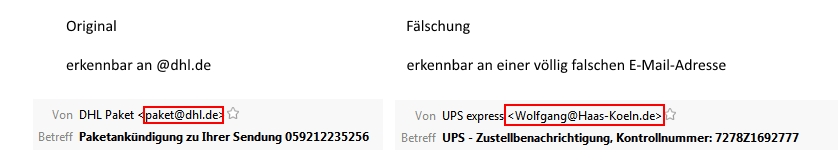

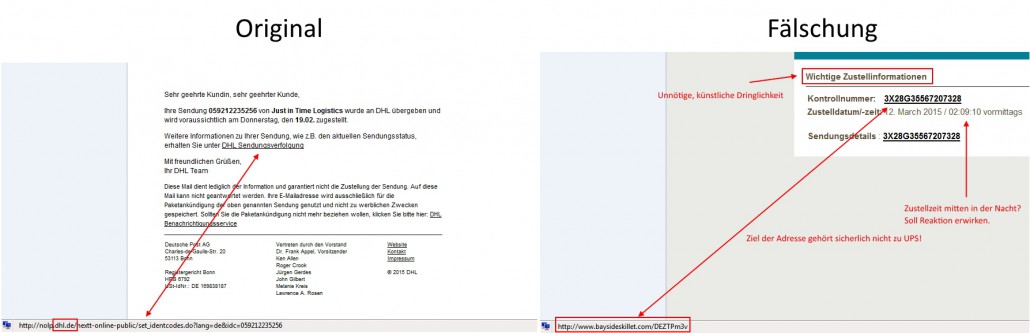

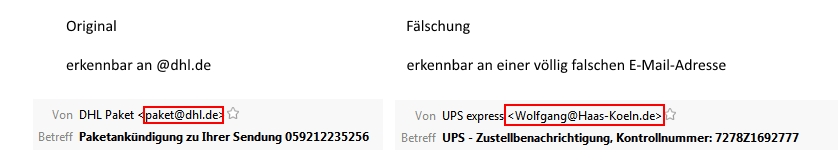

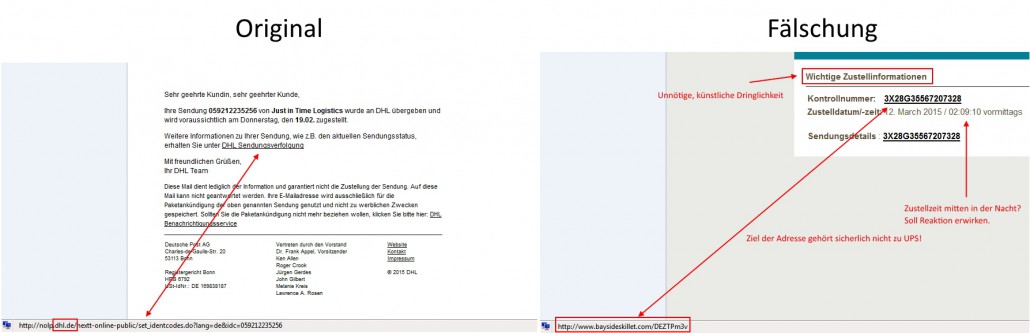

- Eine beliebte Methode ist der Versand von E-Mails mit Links zu irgendwelchen Websites. Der Text weckt meist durch Dringlichkeit bzw. Erwartung die Neugier. Typischer Weise sind diese Mails optisch an bekannte Dienstleister angelehnt z.B. DHL, UPS, Banken, Amazon, Internetanbieter usw.

- Mag die optische Täuschung noch so gelungen, sind diese doch relativ einfach zu enttarnen. Versandadresse sowie das Ziel des Links entlarven Fälschungen meist eindeutig.

- Größere Firmen nutzen üblicher Weise eigene E-Mail-Adressen von ihren Domains. Hier ein Beispiel:

- Ebenso verdächtig sind Links zu Seiten die nichts mit dem Dienstleister zu schaffen haben und garantiert nicht von diesem stammen:

- Die Links zu Seiten werden im Mail-Programm angezeigt, sobald man mit der Maus über diesen Link geht und kurz verharrt. Dieses Vorgehen ist nicht schädlich, nur bitte nicht den Link anklicken. (Einfach mal bei der von mir erhaltenen E-Mail zu diesem Artikel testen).

- Wie auch bei den E-Mail-Adressen benutzen Firmen meist Verweise auf eigene Websites, diese sind dann an am Namen zu erkennen. Schreibfehler oder seltsame Kreationen wie z.B. amazoon.de , pay.pal.de o.ä. sollten direkt Misstrauen erwecken.

- Im Zweifel gilt: Finger weg!

- Beliebt sind auch Fragen nach persönlichen Daten bzw. das „Pakete“ für einen „gefunden“ wurden, aber z.B. die Adresse unvollständig ist. Auch hier hilft es sich kritische Fragen zu stellen wie z.B.:

- Warum sollte mich meine Bank oder ein anderer Dienstleister nach meinen persönlichen Daten fragen?

- Wieso kommt diese (kritische) Anfrage als E-Mail? Und wieso soll ich die Daten irgendwo eintippen?

- Wie konnte etwas „Verlorenes“ ohne Anhaltspunkt wohin es gehört, mir dann überhaupt zugeordnet werden? Und seit wann steht eine E-Mail-Adresse auf dem Paket?

- Wie kommt der Dienstleister überhaupt an meine E-Mail-Adresse?

- Meist scheitern diese Betrugsversuche an simplen logischen Fragen.

- Gefährliche E-Mail-Anhänge sicher enttarnen.

- Egal ob von Bekannten oder Fremden, bei Anhängen sollte man stets misstrauisch sein!

- Schädliche Anhänge lassen sich jedoch sehr einfach identifizieren:

- Rechnungen werden üblicherweise als PDF mit der Endung .pdf verschickt. Der Datei-Typ wird vom E-Mail-Programm angezeigt (ähnlich den Link-Adressen).

- .zip Dateien die angeblich Rechnungen, usw. enthalten sind als verdächtig einzustufen und die gesamte Mail sollte gelöscht werden. Die ZIP-Datei soll „Vertrauen“ durch Bekanntheit wecken und den eigentlichen Dateityp verschleiern. Die .zip selbst ist nicht gefährlich, jedoch deren Inhalt.

- Finger weg von .exe .bat. cmd .htm, .html usw. NIEMAND wird jemals so eine Datei als E-Mail verschicken!

- Keine Anhänge von fremden Quellen öffnen.

- Grundsatz: E-Mails sind NIE dringlich!

- Es stellt sich die Frage was ist eigentlich dringlich und wieso wird es als E-Mail verschickt. Hier ein paar Beispiele:

- Abmahnung o.ä. von Anwälten: Sollte man in Kontakt mit einem seriösen Anwalt kommen, egal wieso, wird dieser einen IMMER per Brief kontaktieren! Alle E-Mail-Nachrichten bezüglich solcher Themen können getrost ignoriert werden!

- Zahlungsaufforderung / Säumnis bei Rechnungen / Mahnungen: Was zwischen Geschäftskunden üblich ist, ist im privaten Umfeld nicht zu erwarten. Absender prüfen, falls dieser unbekannt ignorieren.

- Ergänzung von Daten / Datenverlust: Eine Bank sowie jede seriöse Firme wird niemals eine Aufforderung seine Daten zu aktualisieren, per E-Mail schicken!

- Generell gelten folgende Grundsätze:

- Wenn jemand etwas von einem möchte (z.B. Geld) wird dieser auch weiterhin versuchen einen zu kontaktieren! Notfalls postalisch oder telefonisch! Wenn nicht, ist das sein Problem.

- E-Mails sind nicht rechtskräftig. Sollte man mal eine E-Mail zu viel ignorieren oder falsch einordnen ist dies kein Anlass zur Sorge.

- Es wird weder etwas Schlimmes passieren, noch stirbt jemand, wenn man nicht reagiert.

Fazit

Hält man sich an diese simplen Verhaltensregeln, sinkt die Wahrscheinlichkeit für eine erfolgreiche Attacke enorm. Bei E-Mails sollte man stets im Auge haben, dass es auch noch andere Kommunikationswege gibt und eine akute Dringlichkeit nicht besteht. Diese Tatsache sorgt für Besonnenheit und die Möglichkeit, logisch über den Inhalt der E-Mail nachzudenken. um Fälschungen zu identifizieren. Die Angreifer nutzen die vorgegebene Dringlichkeit oder Wichtigkeit, um beim Opfer Stress und Druck zu erzeugen. Unter diesen Umständen entstehen eher Fehler und logische Bedenken werden zurückgestellt bzw. ignoriert.

Ein bis zwei Minuten Nachdenken werden nicht zur Apokalypse führen. Im schlimmsten Fall erhält man die Informationen eben um diese Zeit später oder der Versender muss sich im Zweifelsfall nochmals melden. Dies ist auf jeden Fall erträglicher, als Gefahr zu laufen, infiziert zu werden. Dies ist in der Regel stressiger und kostspieliger.